cacho

text

Repository Info

About This Server

text

Model Context Protocol (MCP) - This server can be integrated with AI applications to provide additional context and capabilities, enabling enhanced AI interactions and functionality.

Documentation

IA en Metrología: Uso de modelos de lenguaje de gran tamaño (LLM) y aplicaciones en Metrología

🧠 Línea de tiempo del desarrollo de la Inteligencia Artificial

📌 1950 – Alan Turing y el Test de Turing

Publica el artículo "Computing Machinery and Intelligence", donde se pregunta si las máquinas pueden pensar.

📌 1956 – Nace oficialmente la IA

En la conferencia de Dartmouth, John McCarthy acuña el término "Inteligencia Artificial".

📌 1966 – ELIZA

Joseph Weizenbaum crea ELIZA, uno de los primeros programas de procesamiento de lenguaje natural que simulaba una conversación con un psicoterapeuta.

📌 1970s – Primeros robots con IA

Desarrollo de robots como Shakey, capaces de razonar sobre sus acciones en un entorno simple.

📌 1980s – Sistemas expertos

Los sistemas expertos como XCON (de Digital Equipment Corporation) se popularizan, imitando decisiones humanas en áreas específicas.

📌 1997 – Deep Blue vence a Kasparov

La supercomputadora de IBM derrota al campeón mundial de ajedrez, un momento histórico para la IA.

📌 2002 – Primer robot doméstico exitoso: Roomba

Se lanza la aspiradora autónoma que navega por las habitaciones. La IA entra en los hogares.

📌 2011 – Watson gana en Jeopardy!

La IA de IBM vence a los campeones humanos del programa de preguntas y respuestas, demostrando capacidades avanzadas en lenguaje natural.

📌 2012 – Revolución del deep learning

La red neuronal AlexNet gana la competencia ImageNet con gran diferencia, marcando el despegue de las redes neuronales profundas.

📌 2016 – AlphaGo vence al campeón de Go

Desarrollado por DeepMind (Google), vence a Lee Sedol en un juego considerado demasiado complejo para una IA.

📌 2018 – GPT-2 de OpenAI

Un modelo de lenguaje que demuestra capacidades sorprendentes de generación de texto.

📌 2020 – GPT-3 y modelos multimodales

GPT-3, con 175 mil millones de parámetros, se vuelve famoso por su habilidad para escribir, razonar y conversar.

📌 2022 – ChatGPT y DALL·E

OpenAI lanza ChatGPT y DALL·E 2 al público. La IA generativa se vuelve accesible y viral.

📌 2023 – IA generativa en todas partes

Microsoft y Google integran IA en sus productos; ChatGPT se convierte en herramienta diaria para millones.

📌 2024-2025 – Auge de los modelos abiertos y personalizados

Aumenta la creación de modelos personalizados (como Mistral, LLaMA, Claude, etc.) y se exploran regulaciones éticas para su uso.

link a video https://x.com/i/status/1729631340180443177

https://x.com/CodeByPoonam/status/1909973402536013840

📘 Glosario de términos de Inteligencia Artificial

🤖 Inteligencia Artificial (IA)

Simulación de la inteligencia humana en máquinas que pueden razonar, aprender, resolver problemas y adaptarse.

Como cuando una máquina "piensa" o toma decisiones, como lo haría una persona.

🧠 Aprendizaje Automático (Machine Learning)

Subcampo de la IA donde las máquinas aprenden automáticamente a partir de datos sin ser programadas línea por línea.

Es como enseñar a un perro nuevos trucos, pero en vez de golosinas, le das datos.

🧮 Red Neuronal Artificial

Modelo inspirado en cómo funciona el cerebro humano, compuesto por "neuronas" conectadas que procesan información.

Imitan cómo pensamos... aunque con matemáticas y no con emociones.

🧠🔁 Aprendizaje Profundo (Deep Learning)

Tipo de aprendizaje automático que usa redes neuronales muy grandes (con muchas capas).

Es como una red neuronal "supervitaminada", ideal para tareas complejas como entender imágenes o lenguaje.

💬 Procesamiento del Lenguaje Natural (PLN o NLP)

Tecnología que permite a las máquinas entender, interpretar y generar lenguaje humano.

Es lo que usan asistentes como Siri, Alexa o ChatGPT para entenderte cuando hablás o escribís.

📊 Datos de Entrenamiento

Información que se le da a una IA para que aprenda.

Como si le dieras ejemplos a un alumno para que entienda un tema.

📈 Modelo

Representación matemática que la IA crea a partir de los datos para poder hacer predicciones o tomar decisiones.

Es lo que queda "grabado" en la cabeza de la máquina luego de entrenarla.

🎯 Inferencia

Momento en que la IA ya entrenada usa lo que aprendió para dar una respuesta o tomar una decisión.

Como cuando rendís examen con lo que estudiaste.

📦 Dataset (conjunto de datos)

Colección organizada de datos que se utiliza para entrenar o evaluar modelos de IA.

Como una biblioteca llena de ejemplos que la IA consulta para aprender.

🧪 Overfitting (sobreajuste)

Cuando un modelo aprende demasiado bien los datos de entrenamiento y no generaliza bien a nuevos datos.

Como un estudiante que memoriza todo para el examen, pero no entiende nada si le cambian el enunciado.

🧭 Algoritmo

Conjunto de instrucciones que la IA sigue para aprender o resolver un problema.

Una receta de cocina... pero para que una máquina aprenda.

🕵️ Sesgo Algorítmico

Cuando una IA toma decisiones injustas porque los datos con los que fue entrenada están sesgados.

Si solo aprendés de ejemplos injustos, también vas a ser injusto.

🤔 IA Generativa

IA capaz de crear contenido nuevo (texto, imágenes, música, etc.) en lugar de simplemente analizar datos.

Como un robot artista: no solo mira cuadros, ¡también los pinta!

🧱 Token

Unidad básica de texto con la que trabaja una IA de lenguaje (puede ser una palabra, una sílaba o incluso una letra).

Es como una "pieza de Lego" con la que se construyen frases.

🌐 Modelo de Lenguaje (LLM - Large Language Model)

Modelo entrenado con enormes cantidades de texto para entender y generar lenguaje humano.

Como ChatGPT o Bard: leen miles de libros y páginas para poder conversar con vos.

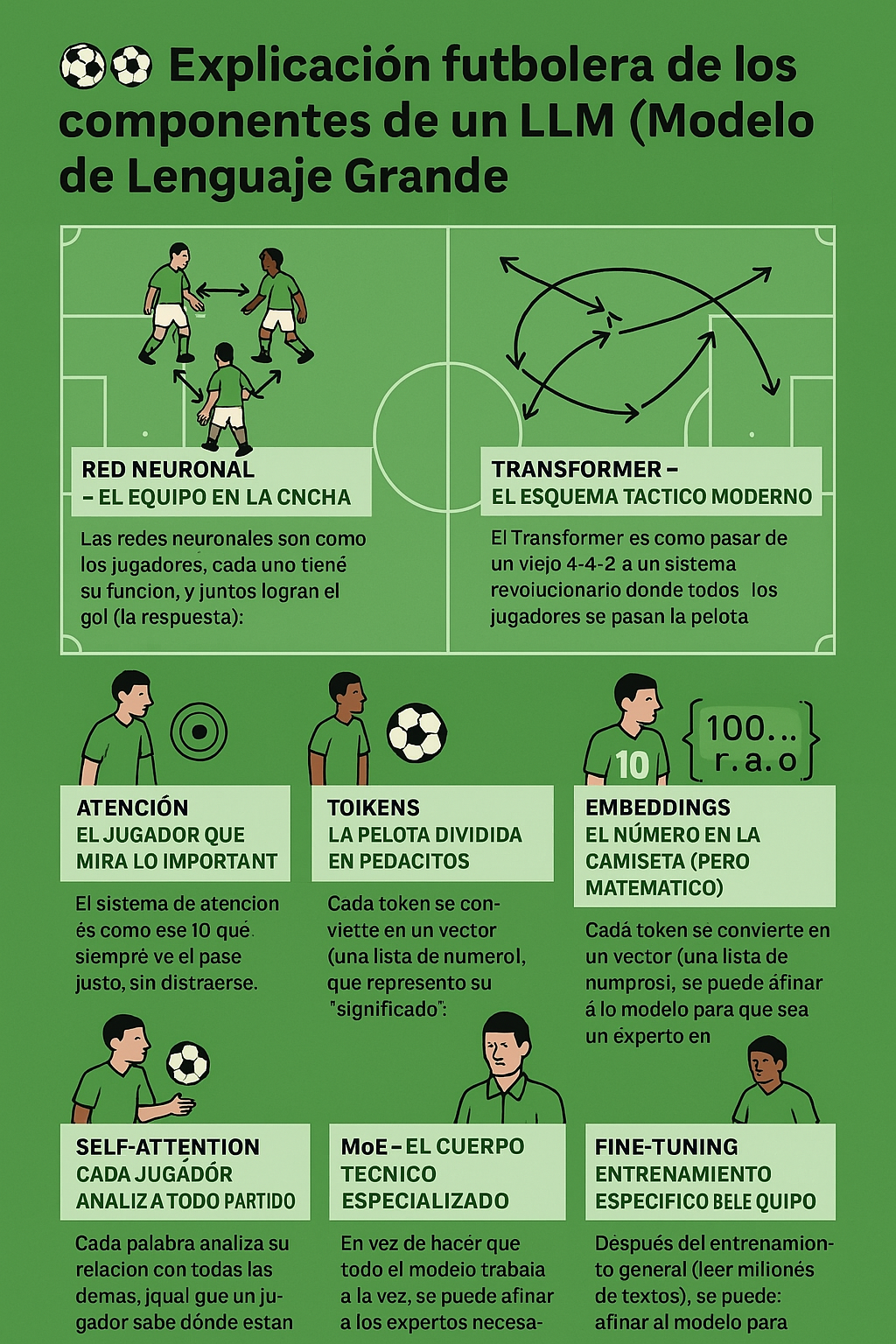

🧠⚽ Explicación futbolera de los componentes de un LLM (Modelo de Lenguaje Grande)

🧠 Red Neuronal – El Equipo en la cancha

Las redes neuronales son como los jugadores: cada uno tiene su función, y juntos logran el gol (la respuesta).

📌 Ejemplo:

Un pase del 5 al 10 que asiste al 9: la info va de una "neurona" a otra, procesándose paso a paso hasta llegar al resultado.

🧱 Capas – Las líneas del equipo (defensa, medio, ataque)

Cada capa procesa la jugada un poco más. Hay capas que "piensan" en defensa, otras en el pase, y otras en definir.

📌 Ejemplo:

Primera capa ve que la palabra es “Messi”, la segunda la asocia con “driblar”, la tercera con “hacer gol”.

¡Jugadón en cadena!

🎯 Atención – El jugador que mira lo importante

El sistema de atención es como ese 10 que siempre ve el pase justo, sin distraerse.

📌 Ejemplo:

En la frase “Maradona gambeteó a cinco ingleses y definió con zurda”, el modelo presta atención a “definió” y relaciona que fue “Maradona” quien lo hizo, no otro.

🤳 Self-Attention – Cada jugador analiza todo el partido

Cada palabra analiza su relación con todas las demás, como si cada jugador en la cancha supiera dónde están los 21 restantes todo el tiempo.

📌 Ejemplo:

“Messi se la pasó a Di María, que le devolvió la pared y luego... gol.”

El modelo conecta todas esas acciones aunque estén separadas en la oración. ¡Jugadas asociadas!

🧭 Transformer – El esquema táctico moderno

El Transformer es como pasar de un viejo 4-4-2 a un sistema revolucionario donde todos los jugadores se pasan la pelota al mismo tiempo.

📌 Ejemplo:

Antes, los modelos iban de palabra en palabra (como un tiki-taka lento).

Con Transformers, leen toda la oración a la vez: ¡juego en equipo simultáneo!

🔤 Tokens – La pelota dividida en pedacitos

El texto se divide en tokens, que son como fragmentos de la jugada. Puede ser una palabra, una parte de palabra o un símbolo.

📌 Ejemplo:

“Cristiano” puede separarse en tokens como ["Crist", "iano"].

¡Hasta los nombres tienen doble marca! 😄

🧮 Embeddings – El número en la camiseta (pero matemático)

Cada token se convierte en un vector (una lista de números), que representa su "significado".

📌 Ejemplo:

“Messi” y “Pelé” pueden tener vectores similares, porque ambos son GOATs.

¡Es como saber que ambos tienen la 10 en el corazón, aunque jueguen en épocas distintas!

👨🏫 MoE (Mixture of Experts) – El cuerpo técnico especializado

En vez de hacer que todo el modelo trabaje a la vez, MoE solo llama a los expertos necesarios.

📌 Ejemplo:

Pedís un análisis táctico → se activa el experto en estrategia.

Pedís una historia de la Libertadores → se activa el historiador futbolero del modelo.

⚙️ Es como que el DT elige a los mejores suplentes para entrar en esa jugada específica.

🛠️ Fine-tuning – Entrenamiento específico del equipo

Después del entrenamiento general (leer millones de textos), se puede afinar el modelo para que sea experto en algo puntual.

📌 Ejemplo:

Un LLM general aprende de todo. Pero si lo entrenás solo con textos de fútbol... ¡se convierte en BilardoGPT!

📚 Preentrenamiento – El potrero, el baby, la formación base

El LLM primero se forma leyendo de todo: libros, artículos, tweets, etc.

Así "aprende a jugar". Después, con Fine-tuning, lo llevás a jugar a tu equipo.

📌 Ejemplo:

Primero aprende lo que es un corner, una chilena y una final. Luego lo entrenás para que analice partidos del Mundial.

🏁 Conclusión:

Un LLM es como un equipo tácticamente brillante, con jugadores (neuronas), un esquema moderno (transformer), visión de juego (atención) y entrenadores que afinan su rendimiento (MoE y Fine-tuning).

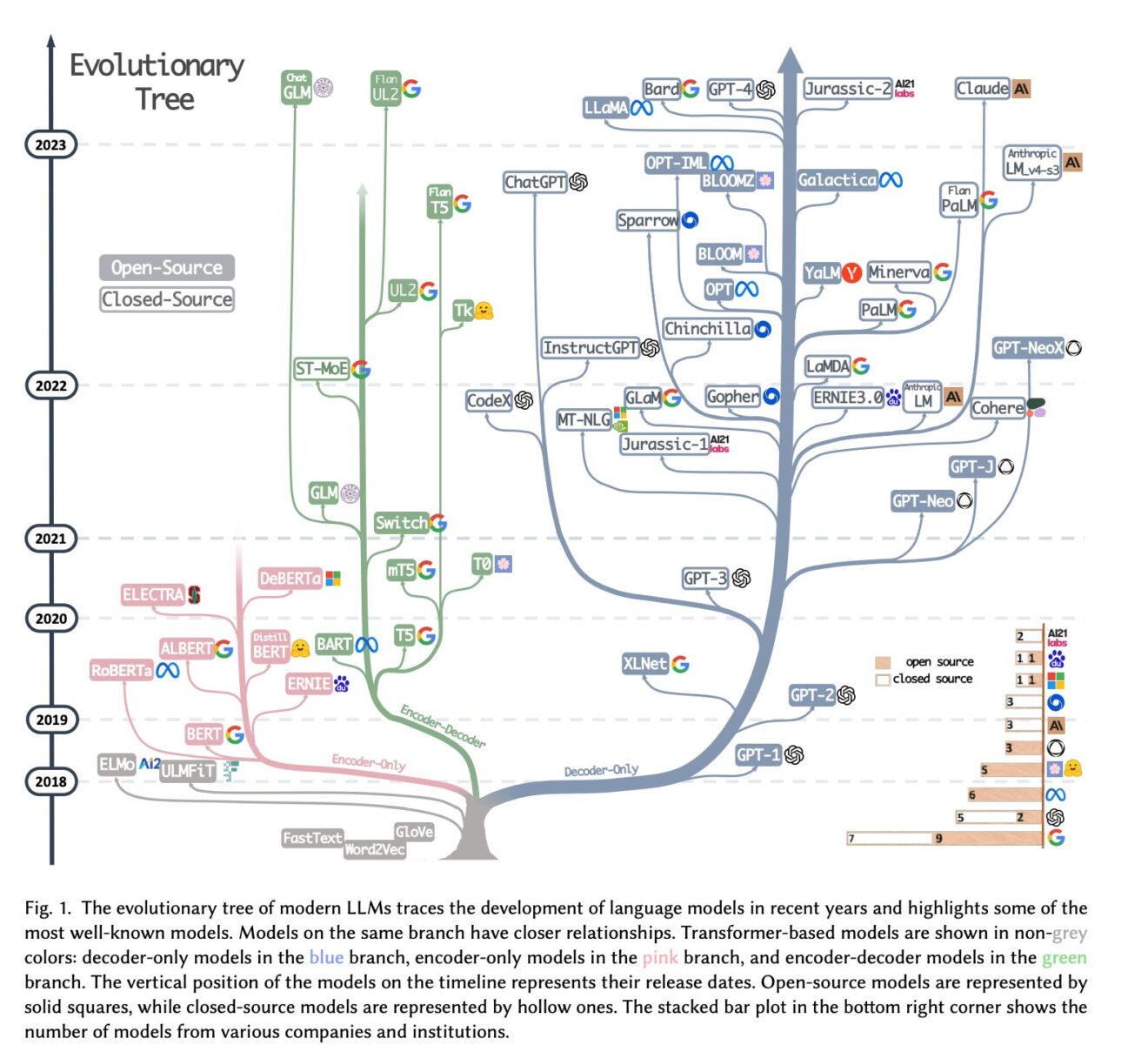

📈⚙️ Evolución de los LLM: Tamaño vs Rendimiento

| Año | Modelo | Tipo | Parámetros (aprox.) | MMLU (%) | Observaciones clave |

|---|---|---|---|---|---|

| 2020 | GPT-3 | Pago (OpenAI) | 175B | ~43% | El primero en causar impacto global. |

| 2021 | Jurassic-1 Jumbo (AI21) | Pago | 178B | ~45% | Similar a GPT-3, menor adopción. |

| 2021 | Gopher (DeepMind) | Privado | 280B | 60% | Muy buenos resultados en benchmarks. |

| 2022 | PaLM (Google) | Privado | 540B | ~65% | Gran salto en lenguaje y razonamiento. |

| 2022 | BLOOM | Open Source | 176B | ~35% | Primer modelo multilingüe grande OSS. |

| 2023 | GPT-4 | Pago (OpenAI) | ~1T (estimado) | ~86.4% | Supera el promedio humano en MMLU. |

| 2023 | Claude 2 (Anthropic) | Pago | ~100B (estimado) | ~75% | Fuerte en alineación y redacción. |

| 2023 | LLaMA 2 (Meta) | Open Source | 7B, 13B, 70B | ~67% (70B) | Buen rendimiento OSS y más accesible. |

| 2024 | Mistral 7B | Open Source | 7B | ~68% | Modelo compacto, pero potente. |

| 2024 | Mixtral 8x7B (MoE) | Open Source | 12.9B activos / 46.7B total | ~75% | Uso eficiente de expertos (MoE). |

| 2024 | Claude 3 Opus | Pago | ? | ~88.7% | Top en benchmarks, fuerte en análisis. |

| 2024 | Gemini 1.5 (Google) | Pago | ? (rumores 1.6T) | ~87–89% | Avance en contexto largo. |

| 2024 | Command R+ (Cohere) | Open Source | ? | ~70–75% | Optimizado para RAG. |

| 2024 | GPT-4-turbo | Pago (OpenAI) | ? (~1.5T estimado) | ~88% | Misma calidad que GPT-4, más barato. |

📌 Notas:

- MMLU (Massive Multitask Language Understanding) es un benchmark que mide comprensión en temas académicos como historia, lógica, ciencia, etc.

- Algunos modelos open source (OSS) como LLaMA 2 y Mixtral se acercan al rendimiento de modelos comerciales, aunque siguen un poco por debajo en tareas complejas.

- MoE (Mixture of Experts) permite usar grandes cantidades de parámetros sin activar todos al mismo tiempo, mejorando eficiencia.

- Hay una tendencia a modelos más eficientes, no solo más grandes.

Conceptos de Entrenamiento LLM

🧠🔧 1. Pre-training (preentrenamiento)

¿Qué es?

Es cuando un modelo de IA aprende de una gran cantidad de textos, sin un objetivo específico.

Aprende a "entender el mundo" leyendo de todo: Wikipedia, redes sociales, noticias, recetas, chats, etc.

🧍♀️ Ejemplo cotidiano:

Es como cuando un chico o chica aprende sobre el mundo en general: lee libros, ve películas, escucha conversaciones.

Todavía no sabe que quiere ser chef, pero está absorbiendo todo.

👩🍳 Resultado: Tiene una cultura general amplia. Sabe que el tomate va en la ensalada, que Messi juega al fútbol y que el Sol sale por el Este.

🛠️✨ 2. Fine-tuning (ajuste fino)

¿Qué es?

Después del preentrenamiento, el modelo se especializa en una tarea concreta.

Se le entrena con ejemplos específicos para que se vuelva experto en eso.

🧍♀️ Ejemplo cotidiano:

Volvamos a la persona que aprendía de todo. Ahora quiere ser chef. Se anota en un curso de cocina italiana y empieza a practicar solo eso: pastas, risottos, salsas.

🍝 Resultado: Ya no es solo alguien "que sabe cosas". Ahora es un chef de cocina italiana.

💬🧑💻 3. Prompt Engineering (ingeniería de indicaciones)

¿Qué es?

Es el arte de dar las instrucciones justas al modelo para que haga lo que querés.

No entrenás al modelo, solo le hablás con claridad.

🧍♀️ Ejemplo cotidiano:

Le pedís a alguien que te haga un café. Si le decís:

- “Quiero un café solo, sin azúcar, en taza chica.” → ¡Lo hace perfecto!

- Si solo decís: “Café…” → Te puede traer cualquier cosa.

🧠 Resultado: Cuanto mejor le pedís las cosas, mejor las hace.

🎯🧪 4. Prompt Tuning (ajuste de indicaciones)

¿Qué es?

Es como ponerle un “disfraz mental” al modelo: un prompt preconfigurado que le cambia el comportamiento automáticamente, sin reentrenarlo.

🧍♀️ Ejemplo cotidiano:

Imaginá que tenés una receta escrita que siempre le das a tu hermana para que cocine tu plato favorito.

No tenés que enseñarle a cocinar de nuevo cada vez: le das tu prompt especial y listo.

🍽️ Resultado: Cada vez que use esa receta, va a cocinar exactamente como a vos te gusta.

| Concepto | En la vida cotidiana | Resultado |

|---|---|---|

| Pre-training | Aprender de todo antes de saber para qué | Cultura general |

| Fine-tuning | Especializarse en algo (como ser chef o electricista) | Experto en un área |

| Prompt engineering | Saber cómo pedir lo que querés para que te entiendan | Mejor comunicación |

| Prompt tuning | Usar un mensaje prearmado que da siempre el mismo resultado | Automatización de pedidos |

✅ LO QUE SÍ HACE UN LLM (en términos mundanos)

🧠 1. Completa palabras como un experto en crucigramas

- Un LLM predice qué palabra sigue en una oración basándose en todo lo que leyó antes.

- 📌 Ejemplo: Si decís “Hoy hace calor, voy a la...”, probablemente diga “playa”.

📚 2. Es como una enciclopedia que escribe lindo

- Sabe muchos datos (porque leyó mucho), y los organiza en respuestas claras.

- 📌 Ejemplo: Le preguntás “¿Quién fue San Martín?” y te da una respuesta bien redactada.

🎭 3. Actúa personajes

- Puede “hacerse pasar” por un chef, un contador, un profe o incluso un robot de otra galaxia.

- 📌 Ejemplo: Le decís “actuá como un entrenador de fútbol” y cambia el estilo de respuesta.

🧩 4. Te ayuda a pensar y ordenar ideas

- Puede ayudarte a escribir textos, resumir cosas, organizar tareas o reescribir algo complicado.

- 📌 Ejemplo: Le pasás un texto de un decreto y te lo traduce a “lenguaje humano”.

❌ LO QUE NO HACE UN LLM (aunque parezca que sí)

🚫 1. NO piensa ni razona como un humano

- No “entiende” ni “reflexiona”. Solo predice la mejor frase basada en su entrenamiento.

- 📌 Ejemplo: Puede parecer que “sabe” filosofía, pero solo arma frases filosóficas coherentes.

🚫 2. NO tiene conciencia ni emociones

- No se enoja, no está feliz, no tiene opinión propia. Solo simula emociones si se lo pedís.

- 📌 Ejemplo: Si dice “me alegra ayudarte”, no está sintiendo alegría. Es una forma de hablar amable.

🚫 3. NO busca en internet (por sí solo)

- A menos que esté conectado a una herramienta externa, lo que sabe viene de lo que aprendió hasta cierta fecha.

- 📌 Ejemplo: Si le preguntás el clima actual y no está conectado, va a inventar o decir que no puede saberlo.

🚫 4. NO tiene experiencias del mundo real

-

No ha “vivido” nada: no viajó, no cocinó, no fue a la escuela. Solo leyó sobre eso.

-

📌 Ejemplo: Puede darte una receta, pero nunca probó si queda rica.

Áreas generales de aplicación de los modelos LLM según sus características

Los modelos de lenguaje de gran escala (LLM) pueden aplicarse en diversas áreas según sus características particulares. Aquí te explico las principales:

Según su creatividad

- Generación de contenido creativo: Creación de historias, poesía, guiones y otros textos creativos.

- Publicidad y marketing: Generación de eslóganes, copys y campañas creativas.

- Diseño conceptual: Ayuda en lluvia de ideas para proyectos creativos.

- Entretenimiento: Creación de juegos narrativos, experiencias interactivas.

Según su alucinación (generación de información incorrecta)

- Investigación exploratoria: Generación de hipótesis que luego deben verificarse.

- Brainstorming: Producción de ideas novedosas sin restricciones iniciales.

- Ficción y narrativa: Donde la precisión factual no es crítica.

Áreas donde se debe minimizar la alucinación:

- Medicina y salud

- Asesoramiento legal

- Información financiera

- Reportes científicos

Según su especificidad

- Asistencia técnica especializada: Soporte en áreas como programación, diseño técnico.

- Educación personalizada: Explicaciones adaptadas a diferentes niveles de conocimiento.

- Análisis de datos: Interpretación específica de información.

- Traducciones contextuales: Captura de matices específicos entre idiomas.

Según su repetibilidad en las respuestas

- Documentación técnica: Donde la consistencia es crucial.

- Atención al cliente automatizada: Respuestas estandarizadas para consultas comunes.

- Procedimientos y protocolos: Descripción consistente de procesos.

- Sistemas de información: Donde la variabilidad no es deseable.

Según su inteligencia (capacidad de razonamiento)

- Resolución de problemas complejos: Análisis y solución de situaciones multifacéticas.

- Investigación académica: Síntesis de información y generación de insights.

- Asesoramiento estratégico: Análisis de escenarios y recomendaciones.

- Sistemas de apoyo a la decisión: Evaluación de opciones y consecuencias.

Cada aplicación debe considerar el balance entre estas características, eligiendo modelos y configuraciones que se alineen con los objetivos específicos del proyecto o tarea.

Herramientas y ajustes para adaptar LLMs a diferentes casos de uso

Herramientas según el enfoque creativo

Para maximizar la creatividad:

- Temperature setting elevado: Valores entre 0.7-1.0 para aumentar la aleatoriedad y creatividad.

- Top-p (nucleus sampling) alto: Valores entre 0.9-1.0 para mayor diversidad en las respuestas.

- Prompts abiertos: Instrucciones que fomenten la exploración y divergencia.

- Eliminación de restricciones: Reducir limitaciones en las instrucciones.

Para controlar la creatividad:

- Temperature setting bajo: Valores entre 0-0.3 para respuestas más deterministas.

- Top-p bajo: Valores entre 0.1-0.5 para mayor predictibilidad.

- Prompts restrictivos: Con instrucciones específicas y acotadas.

Herramientas para gestionar la alucinación

Para reducir alucinaciones:

- Retrieval-Augmented Generation (RAG): Conectar el modelo a fuentes externas verificadas.

- Sistemas de citas y referencias: Implementar mecanismos que verifiquen información.

- Fact-checking automático: Herramientas que contrastan respuestas con bases de datos.

- Chain-of-thought prompting: Instrucciones que piden razonamiento paso a paso.

Para entornos donde la alucinación es menos crítica:

- Disclaimers automáticos: Advertencias sobre la naturaleza generativa del contenido.

- Moderación humana: Revisión por personas antes de utilizar el contenido.

Herramientas para ajustar la especificidad

Para aumentar especificidad:

- Fine-tuning con datos de dominio: Entrenar modelos con corpus específicos del sector.

- Few-shot learning: Proporcionar ejemplos concretos en el prompt.

- System prompts especializados: Configurar instrucciones de sistema que orienten al modelo.

- Vocabulario controlado: Definir terminología específica a utilizar.

Para respuestas más generales:

- Prompts de alto nivel: Instrucciones más amplias y menos técnicas.

- Eliminación de contexto específico: Reducir la información especializada en el prompt.

Herramientas para controlar la repetibilidad

Para aumentar consistencia:

- Prompt templating: Utilizar plantillas estandarizadas para consultas similares.

- Seed settings: Fijar semillas aleatorias para garantizar respuestas idénticas.

- Temperature cercana a 0: Para maximizar determinismo.

- Output parsers: Herramientas que formatean las respuestas según estructuras predefinidas.

Para permitir variabilidad:

- Randomization factors: Introducir elementos aleatorios deliberadamente.

- Diversity penalties: Configurar penalizaciones para la repetición.

Herramientas para aprovechar la inteligencia

Para tareas de razonamiento complejo:

- Chain-of-thought prompting: Técnicas que fomentan el razonamiento paso a paso.

- Tree of thought: Exploración de múltiples líneas de razonamiento.

- ReAct framework: Combinación de razonamiento y acción.

- Multi-agent systems: Uso de varios modelos que interactúan entre sí.

- Tools augmentation: Conectar el modelo con herramientas externas (calculadoras, bases de datos).

Para tareas más simples:

- Prompt engineering básico: Instrucciones directas sin necesidad de razonamiento.

- One-shot responses: Configurar para obtener respuestas inmediatas sin deliberación.

Plataformas y frameworks relevantes

- LangChain/LlamaIndex: Para construir aplicaciones con RAG y orquestación de modelos.

- Frameworks de evaluación: Como RAGAS, TruLens para evaluar precisión y relevancia.

- Vector databases: Como Pinecone, Weaviate o Chroma para implementar RAG.

- Herramientas de orquestación: Como DSPy o LMQL para definir patrones de razonamiento.

- Plataformas de prompt engineering: Como PromptIDE o PromptFlow para diseñar y testear prompts.

Cada caso de uso requiere una combinación específica de estas herramientas y ajustes, dependiendo de si se prioriza la creatividad, precisión, especificidad, consistencia o capacidad de razonamiento.

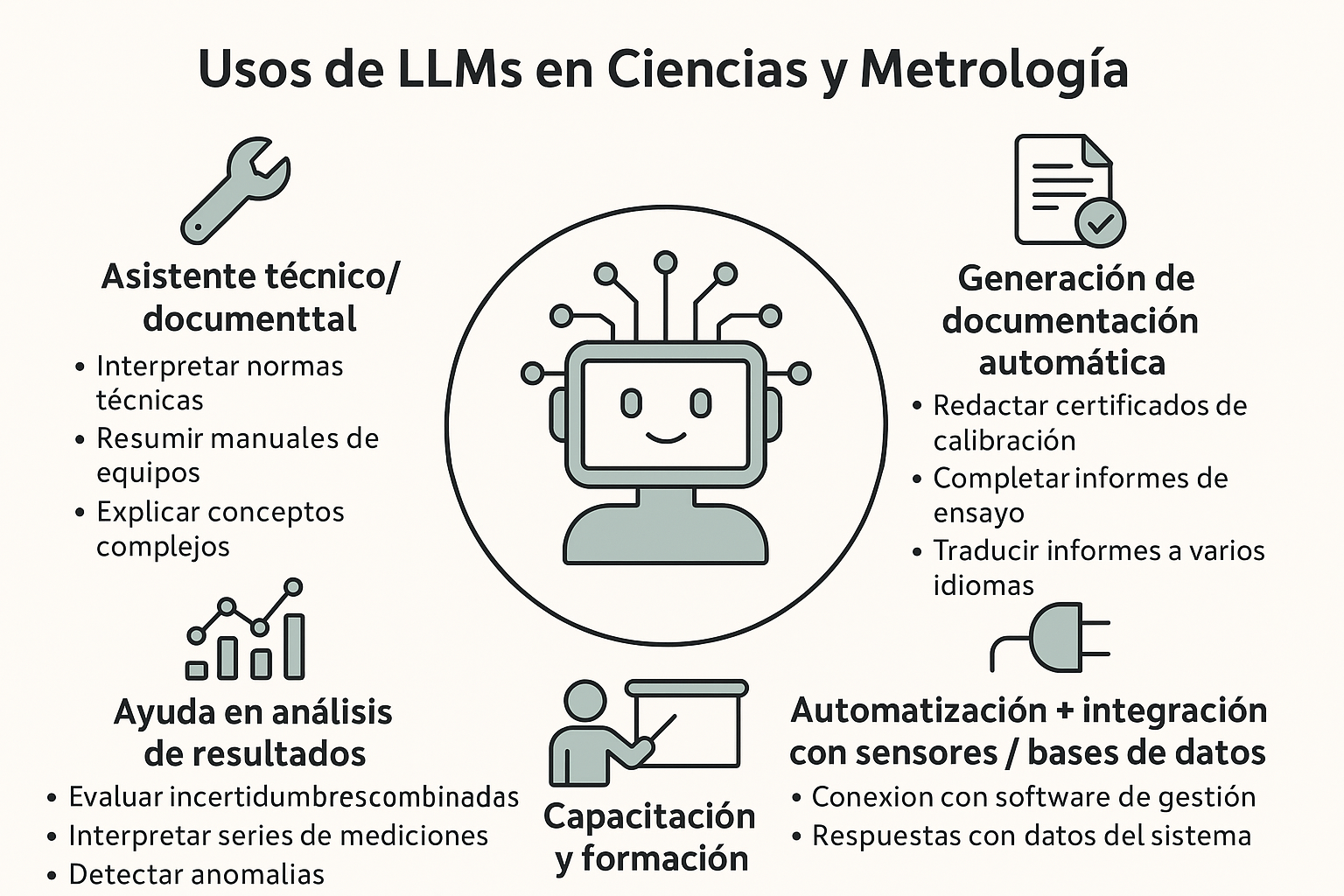

Pregunta: Que ejemplos de uso me darías para el área de ciencias y de la metrología en particular? (Gpt4o_04_2025)

🔬👩🔧 Usos de LLMs en Ciencias y Metrología

🧰 1. Asistente técnico/documental

- 📄 Interpretar normas técnicas (ISO/IEC 17025, VIM, GUM).

- 🔍Private (https://app.clickup.com/9013842807/docs/8cm8mvq-1013/8cm8mvq-1153)

- 🧠 Explicar conceptos complejos como incertidumbre expandida, histéresis o trazabilidad en lenguaje simple.

📌 Ejemplo: “Explícame el error sistemático como si fuera un pastel mal cortado.”

🤖 2. Generación de documentación automática

- 📝 Redactar certificados de calibración (plantillas en lenguaje técnico claro).

- 📋 Completar informes de ensayo o validación con datos ingresados por el usuario.

- 🧾 Traducir informes a varios idiomas técnicos (¡sin perder rigor!).

📌 Ejemplo: Cargás datos de una medición y el LLM te genera un informe con formato acorde a normativa.

📊 3. Ayuda en análisis de resultados

- 🧮Private (https://app.clickup.com/9013842807/docs/8cm8mvq-1013/8cm8mvq-1173)

- 📈 Interpretar resultados de series de mediciones.

- 🤓 Detectar anomalías o inconsistencias lógicas en los datos.

📌 Ejemplo: Le pasás una tabla de resultados y te dice si hay valores atípicos o errores comunes.

🗣️ 4. Capacitación y formación

- 📚 Simulador de examen para auditores.

- 🎓 Profesor virtual que explica según el nivel del estudiante (de aprendiz a experto).

- 🤖 Chat educativo para formación interna en laboratorios.

📌 Ejemplo: Un técnico nuevo puede preguntarle al LLM: “¿Por qué usamos una balanza con resolución de 0,01 mg para esta calibración?” y recibe una respuesta pedagógica.

🔌 5. Automatización + integración con sensores / bases de datos

- 🧩 Conexión con software de gestión metrológica (tipo MET/TEAM, Qualiex).

- 📡 LLM que responde preguntas en lenguaje natural con datos del sistema:

- “¿Qué patrón venció esta semana?”, “¿Cuántos certificados se emitieron este mes?”.

📌 Ejemplo: Un LLM conectado a tu base de calibraciones que te responde como si fuera tu ayudante.

🎯 Extra: Casos futuristas (pero posibles)

- Auditorías virtuales asistidas por IA: ayuda en tiempo real durante una auditoría, corrigiendo errores en la documentación.

- Análisis predictivo de fallas: con IA que combina historial de instrumentos, errores y uso.

- Firma digital + generación automática de DCC (Digital Calibration Certificates).

Mas allá del uso inicial de los LLM - Herramientas - Tendencias

⚙️🌟 1. RAG (Retrieval-Augmented Generation)

"Cuando el modelo no sabe, ¡que busque!"

¿Qué hace?

RAG combina un modelo LLM con una base de datos de conocimiento externo. El modelo no "inventa" todo desde la nada, sino que primero recupera información relevante y luego genera la respuesta con eso.

Ejemplo cotidiano:

📚 Estás preparando una exposición sobre Marte. No te acordás los datos exactos, así que abrís tu carpeta de apuntes, leés rápido, y luego armás la presentación. Eso es RAG: buscar + redactar.

Aplicación real:

- Chatbots que responden usando documentos de tu empresa.

- LLMs conectados a bases de datos científicas o manuales técnicos.

🧠🧭 2. ReAct (Reason + Act)

"Primero pienso, después actúo (como un buen detective)"

¿Qué hace?

El modelo combina razonamiento paso a paso con la capacidad de ejecutar acciones externas, como buscar en Google, hacer cálculos, o consultar una API.

Ejemplo cotidiano:

🤔 Querés saber cuánto tenés que pagar si dividís una cuenta en 3 con propina. Pensás:

- ¿Cuánto fue la cuenta?

- ¿Qué porcentaje dejo de propina?

- Ahora calculo.

- Eso es ReAct.

Aplicación real:

- Agentes conversacionales que resuelven problemas matemáticos o financieros.

- Sistemas que combinan pensamiento + acciones reales.

🤖🪤 3. Agentes (Agents)

"Un asistente que se manda solo a cumplir tareas complejas"

¿Qué hace?

Los agentes usan LLMs como cerebro, pero además tienen "herramientas" para hacer tareas: abrir archivos, mandar mails, buscar datos, llamar APIs, etc.

Ejemplo cotidiano:

💼 Le decís a tu asistente: “Reservame un vuelo barato a Mendoza, confirmame el hotel y avisale a mamá”. Si tu asistente lo hace todo solo, ¡es un agente!

Aplicación real:

- AutoGPT, AgentGPT, CrewAI: hacen planes y los ejecutan.

- Automatización de tareas con múltiples pasos.

🧩📂 4. LangChain / LlamaIndex (Frameworks de orquestación)

"Un sistema para coordinar todo lo anterior"

¿Qué hacen?

Son marcos de trabajo que te ayudan a conectar LLMs con bases de datos, APIs, documentos, herramientas, etc.

Ejemplo cotidiano:

🎮 Es como una consola donde configurás a tu equipo: "Este hace búsquedas", "Este razona", "Este traduce", y todos trabajan juntos.

Aplicación real:

- Chatbots personalizados con tu información.

- Flujos de trabajo inteligentes.

💭📋 5. Prompt Engineering / Prompt Tuning

"Cómo hablarle al modelo para que haga lo que querés"

¿Qué hacen?

Diseñar prompts efectivos es clave para lograr buenos resultados. A veces incluso se entrena al modelo con ejemplos de prompts ajustados (eso es tuning).

Ejemplo cotidiano:

🧑 “No me entiendes si te digo ‘hacé lo tuyo’, pero si te digo ‘hacé una lista de compras solo con verduras verdes para el almuerzo’, sí.”

Aplicación real:

-

Mejorar la calidad de respuestas.

-

Interfaces donde el usuario no ve el prompt real, pero se ajusta “detrás del telón”.

Otras:

| Técnica | Explicación breve | Ejemplo cotidiano |

|---|---|---|

| Tool Use (Herramientas) | El LLM usa cosas externas como calculadoras, traductores, o buscadores. | Pedís ayuda a una app para convertir medidas mientras cocinás. |

| Fine-Tuning / LoRA | Se entrena al modelo con tus propios datos. | Enseñás a tu asistente a hablar con modismos de tu ciudad. |

| Function Calling | El modelo puede llamar funciones específicas programadas. | "Reservá turno" → llama a reservarTurno(fecha, persona). |

| Memory (memoria contextual) | El modelo recuerda interacciones pasadas. | Tu asistente recuerda que odiás el cilantro 🌿. |

| Chain-of-Thought | El modelo razona paso a paso. | Como hacer una multiplicación larga “con cuenta” en vez de mental. |

📜 Lista de preguntas realizadas (chatgpt4o)

-

¿Podés hacerme una línea de tiempo con los principales hechos en el desarrollo de la inteligencia artificial hasta nuestros días?

-

¿Podés darme un listado de terminología y definiciones explicadas de IA?

-

¿Podés darme una explicación con ejemplos amenos de redes neuronales, capas, atención, transformers, MoE y demás elementos que conforman los actuales LLM?

-

¿Podés explicarlo con ejemplos de fútbol?

-

¿Podés hacerlo en forma de infografía futbolera?

-

¿Podés darme un esquema de evolución de los LLM en cuanto a tamaño y rendimiento en tests de inteligencia, tanto de modelos pagos como open source?

-

¿Podés generar un gráfico comparando los tamaños y rendimientos con naves de ciencia ficción?

-

¿Podés darme una explicación de los conceptos de pre-training, fine-tuning, prompt engineering, prompt tuning con ejemplos de la vida cotidiana?

-

¿Podés hacerlo en formato de infografía?

-

¿Qué es lo que un LLM “hace” y lo que “no hace” en términos mundanos?

-

¿Qué ejemplos de uso me darías para el área de ciencias y de la metrología en particular?

-

¿Podés generar una infografía sobre eso?

-

¿Qué otros programas similares a LLM Studio existen para implementar modelos LLM en forma local?

-

¿Hay más?

-

¿Podés agregar los links de acceso a todos?

-

¿Cuáles son las herramientas y tendencias actuales en el ecosistema de generación de herramientas utilizando LLMs? (RAG, ReAct, agentes, MCP y otras) Explicadas con ejemplos cotidianos.

-

¿Qué significa exactamente MCP servers?

Private (https://app.clickup.com/9013842807/docs/8cm8mvq-1013/8cm8mvq-1213)

Private (https://app.clickup.com/9013842807/docs/8cm8mvq-1013/8cm8mvq-1233)

uso de chatgpt

proyectos SIM

Quick Start

Clone the repository

git clone https://github.com/cachodeborg-lab3/cachoInstall dependencies

cd cacho

npm installFollow the documentation

Check the repository's README.md file for specific installation and usage instructions.

Repository Details

Recommended MCP Servers

Discord MCP

Enable AI assistants to seamlessly interact with Discord servers, channels, and messages.

Knit MCP

Connect AI agents to 200+ SaaS applications and automate workflows.

Apify MCP Server

Deploy and interact with Apify actors for web scraping and data extraction.

BrowserStack MCP

BrowserStack MCP Server for automated testing across multiple browsers.

Zapier MCP

A Zapier server that provides automation capabilities for various apps.